Apple pourrait analyser vos photos pour lutter contre la pédopornographie

Apple a présenté, jeudi 5 août, de nouveaux outils afin d’identifier plus efficacement les contenus pédopornographiques sur ses appareils et services. D’ici à la fin de l’année, l’entreprise introduira un nouvel outil qui scannera certaines images hébergées sur iCloud.

Apple annonce des mesures contre la pédopornographie

Apple a dévoilé jeudi 5 août de nouveaux outils destinés à mieux repérer les images à caractère sexuel impliquant des enfants sur ses appareils et services d’hébergement iCloud, suscitant les inquiétudes de défenseurs de la vie privée sur Internet.

D’ici à la fin de l’année, au moment du déploiement d’iOS 15 et des nouveaux systèmes d’exploitation pour ses iPad, ordinateurs Mac et montres connectées, l’entreprise introduira un nouvel outil qui scannera certaines images afin de déterminer si elles peuvent correspondre à des contenus pédopornographiques.

Deux nouveaux outils de surveillance seront en effet mis en place prochainement dans les systèmes d’Apple.

La vie privée en danger… ou pas ?

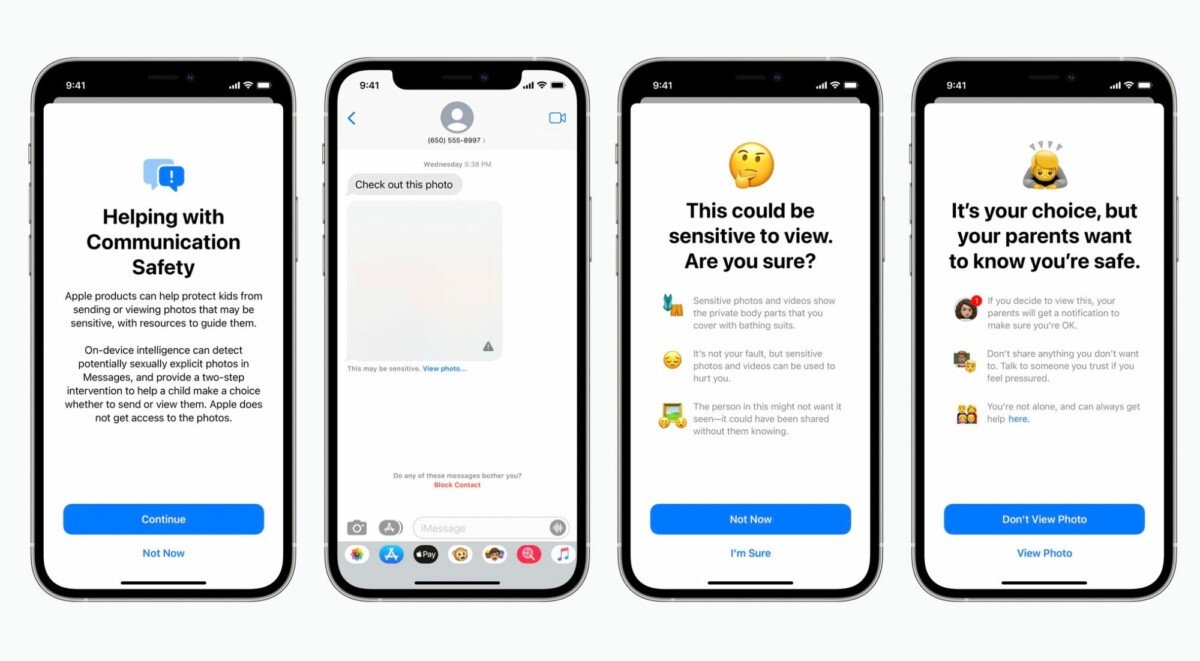

Tout d’abord, le premier outil analysera les photos envoyées ou reçues par un utilisateur mineur d’iMessage pour détecter des images pornographiques.

Dans un compte iCloud familial, si un enfant reçoit ou tente d’envoyer des photos sexuellement explicites, l’image sera alors floutée. De plus, un message d’avertissement sera affiché sur l’écran.

Enfin, l’autre outil analysera les photos sauvegardées sur iCloud pour détecter des images pédopornographiques. Dans les deux cas, cette analyse est faite en local sur l’appareil. Selon Apple, ce processus permet de préserver au maximum la confidentialité des données.

Certes, Apple ne pourra pas voir directement ce qui est échangé, mais il n’y a plus de confidentialité totale sur la communication. Un tel système présente par ailleurs le risque qu’il soit un jour élargi à d’autres cibles. Au-delà des mineurs, pourquoi ne pas regarder si des images sont échangées entre adultes ? Et pourquoi ne pas analyser les textes pour détecter des criminels ou des opposants politiques ? Tout est possible, mais rien n’est transparent, car le modèle d’intelligence artificielle est une propriété privée d’Apple… C’est une boîte noire à laquelle il faut faire confiance. Sur Twitter, les réactions n’ont pas tardé…

Encore un peu de temps ? Découvrez comment ajouter votre pass sanitaire à l’Apple Wallet !