Llama 4 Maverick ne serait pas aussi intelligent que Meta a voulu le faire croire

Actuellement, les géants de la tech se livrent une bataille féroce dans le domaine de l’intelligence artificielle. Dans cette course effrénée, il se murmure que certains se livreraient à des pratiques peu conventionnelles. Une entreprise est justement accusée de se livrer à ces pratiques : Meta.

Meta aurait triché pour dépasser ChatGPT, Gemini et consorts

La maison mère de Facebook a récemment publié sa nouvelle génération de modèles d’intelligence artificielle. Néanmoins, plusieurs experts soupçonnent l’entreprise d’avoir sciemment surestimé les capacités de ces modèles pour qu’elles paraissent plus intelligentes que celles d’OpenAI ou de Google. Selon TechCrunch, Facebook avait tenté de tricher sur un test spécifiquement conçu pour mesurer l’efficacité des grands modèles de langage.

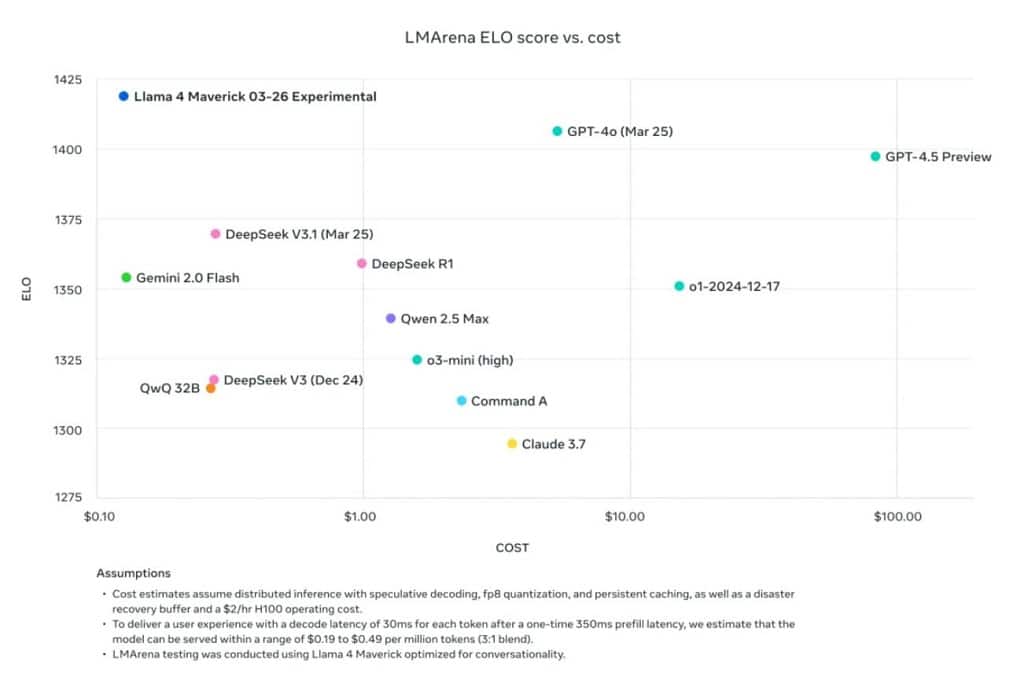

L’histoire commence avec le site LMArena, qui peut a priori indiquer via des scores simples quelle intelligence artificielle est la plus performante sur le marché. Lors de la publication des nouveaux modèles d’IA, Llama 4 Maverick a fait les gros titres. Cette IA semblait légèrement dépasser la concurrence sur les tests de LMArena. D’ailleurs, elle semblait avoir franchi une nouvelle étape sur ce qu’un modèle d’IA est capable de faire. Ce qui est d’autant plus impressionnant car il s’agit d’un produit open source utilisable par tous.

Le modèle de Llama 4 Maverick soumis par Meta est différent du modèle open source

Néanmoins, il semblerait que ce résultat est erroné. Le modèle spécifiquement mis en ligne sur le site de comparaison serait en réalité différent de ce que Meta a mis à disposition du public. Selon LMArena, il s’agissait d’une version « expérimentale ». Alors que le modèle public était loin d’être impressionnant dans ses réponses. Certains experts soupçonnent Meta d’avoir entraîné ce modèle expérimental sur des données spécifiquement conçues pour le faire se distinguer dans les tests de LMArena.

Toutefois, un porte-parole de Meta a nié avoir eu recours à ces méthodes. Il a juste expliqué que tous les prestataires offrant un accès au nouveau modèle n’avaient pas encore fini de le paramétrer, ce qui expliquerait les différentes de performance. Par ailleurs, un graphique sur le site de Meta indique que le modèle soumis au test était « optimisé pour la conversation ».